För ungefär samma pengar får man en Mac med lika mycket RAM och lika stor disk. Kollade lite CPU-benchmarks, 14900HX hänger ju med (fast den drar 3-4 gånger mer...), men M3 Max är i de flesta fall snabbare både i ST och MT (framförallt kompilering vilket lär vara en sak den här typen av maskiner används till).

Kan tyckas vara förvånande att fördelen i CPU-prestanda faktiskt är något större i MT då 14900HX har totalt 24 kärnor och 32 trådar mot 16 kärnor och 16 trådar hos M3. Men MT är ett område där ARM64 specifikt har fördelar mot x86_64, det på ett sätt som bara kan fixas för den senare genom att paja bakåtkompatibilitet.

GPU-mässigt råder det inget tvivel om att RTX 4090 Laptop är snabbare, GPUn i M3 Max ligger mellan 4070 och 4080 i prestanda. Ävenom Apple också här leder i perf/W, är fördelen är inte alls lika stor som på CPU sidan. GPUn i M3 Max ha uppmäts ha peak-effekt på ~50 W. 4090 ligger på 175 W, 4080 på 150 W och 4070 på 115 W.

Men en annan sak som gör en sådan här produkt värd priset är AI-hysterin. Nvidia är ledande med CUDA, men den som är överlägset närmast Nvidia i programvarustöd just nu är Apple. Alla de populära ramverken för AI/ML har "native" stöd för MacOS. Ovanpå det har AI/ML-stödet för ARM64 förbättrats väldigt snabbt då både Apple och Nvidia hjälps åt då Nvidias egen serverplattform använder Arm Neoverse V2 CPU-kärnor.

4090 är utan tvekan snabbare än M3 Max, men så fort man börjar ge sig på LLMs (vilket lär vara där hysterin är som störst just nu) eller "bara" har fall som mår bra av stora dataset (vilket rätt snabbt blir fallet så fort det blir lite mer komplex) har M3 Max en enorm fördel i att den har i praktiken ~100 GB VRAM tillgänglig mot 16 GB för 4080/4090.

Så just AI/ML är nog killer-featurn för M3 just nu och det som enklast kan motivera 70k för en bärbar. De andra möjligheterna att ens kunna jobba med så stora dataset är CPU, med långt sämre prestanda, eller datacenter GPUer som startar norr om 100k...

Ett snabbtest med LM Studio på Acer-datorn hade var spännande. GPU-mässigt borde det AMD testade här ge >60 tok/s med GPU, ingen aning var CPU-delen kan tänkas hamna. Det är ändå ett fullt rimligt use-case för den här typen av dator.

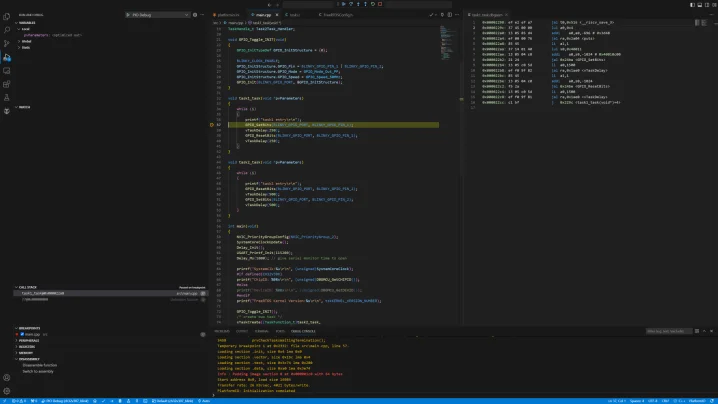

Ett test kräver

LM Studio och denna modell. Söker man efter "mistral-7b-finetuned-orca-dpo-v2-Mistral-7B-Instruct-v0.2-slerp-GGUF" i LM Studio kommer rätt modell upp, ska vara den som är 5,94 GB för att testa de som testas i listan jag postade här (så resultatet kan sättas i relation till något).

Varje gång man ställer en fråga visa prestanda-statistik längst ned. En prompt jag sett folk använda som "benchmark" då det ger ett rätt långt svar är "Tell me about Mars". Egen testning visar att tok/s är rätt konstant oavsett vad frågan handlar om.

Nu finns det säker någon som köper en sådana här laptop som gaming-maskin, men det kanske inte är vad enheten är optimerad för...

Givet att AI/ML i väldigt stor utsträckning körs på Linux (ett klagomål på både PyTorch och TensorFlow är att samma HW presterar bättre under Linux jämfört med Windows, framförallt GPU-accelerering med CUDA) vore det spännande att veta hur bra/dåligt Linux stödet är på den här maskinen. Givet att AI/ML är en av nog rätt få saker som kan motivera inköp av den här typ av bärbara vore det kul med ett snabbtest av t.ex. Ubuntu. Se att det i alla fall bootar, all HW hittas och fungerar + något snabbtest, allt detta kan göras från en USB-sticka/disk utan att röra Windows-installationen.

Även Blender uppvisar bättre prestanda under Linux, är inget jag personligen bryr mig speciellt mycket i men skulle kunna användas som snabbtest av att GPU/CUDA fungerar.

Skrivet av AlbinLoan:

Första gången jag ser en konsument PC-laptop med Apple priser.

Tycker det är precis vad man brukar se, om något ligger just denna dator rätt bra i pris mot Apple då det faktiskt oftare är så att Windows-laptops tenderar bli dyrare än Mac:arna om de på något sätt är jämförbara i kvalité och prestanda.