CCNP Enterprise + SPCOR

FCSS Network Security

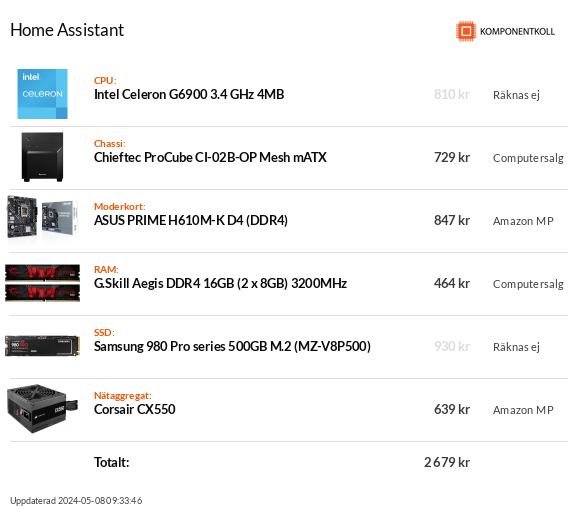

Söker billig SSD med hög uthållighet (Endurance/TBW) till Home Assistant.

Mostly Harmless

Ryzen 5800X3D | 64 GB Ram | 7900 XTX | Samsung 990 Pro 4 TB + Seagate FireCuda 520 2TB * 2

Laptop: Core 9 Ultra 185H | 24GB Ram | RTX 4060 | 3 TB NVME

Server: Fractal design Define 7 XL | AMD Ryzen 7 5800X 8/16 | ASUS ROG CROSSHAIR VIII DARK HERO | 64GB Corsair @ 3000MHz | ASUS Radeon RX 460 2GB | Samsung 960 PRO 512 GB M.2 | 2x 2TB Samsung 850 PRO SSD | 6x Seagate Ironwolf Pro 10TB

WS: Phantex Entoo Elite | AMD Ryzen Threadripper 1950X 16/32 | ASUS Zenith extreme | 128GB G.Skill @ 2400MHz | ASUS Radeon HD7970 | 3x 2TB Samsung 960PRO M.2 | 6x Seagate Ironwolf Pro 10 TB

NEC PA301W 30" @ 2560x1600 | Linux Mint 21.3 Cinnamon

| PM:a Moderatorerna | Kontaktformuläret | Geeks Discord |

Testpilot, Skribent, Moderator & Geeks Gaming Huvudadmin

ASUS P8Z68-v Pro i7 2600K@4.5, 32GB RAM, RX 580, 4K Samsung u24e590, Intel SSD, Seagate SSHD, LG BH16NS55 BD/RW, MacOS Monterey, Win 10+11, Linux Mint

Macbook Pro 2009, 8GB RAM, SSD, MacOS Catalina + Windows 7

Server: Fractal design Define 7 XL | AMD Ryzen 7 5800X 8/16 | ASUS ROG CROSSHAIR VIII DARK HERO | 64GB Corsair @ 3000MHz | ASUS Radeon RX 460 2GB | Samsung 960 PRO 512 GB M.2 | 2x 2TB Samsung 850 PRO SSD | 6x Seagate Ironwolf Pro 10TB

WS: Phantex Entoo Elite | AMD Ryzen Threadripper 1950X 16/32 | ASUS Zenith extreme | 128GB G.Skill @ 2400MHz | ASUS Radeon HD7970 | 3x 2TB Samsung 960PRO M.2 | 6x Seagate Ironwolf Pro 10 TB

NEC PA301W 30" @ 2560x1600 | Linux Mint 21.3 Cinnamon

| PM:a Moderatorerna | Kontaktformuläret | Geeks Discord |

Testpilot, Skribent, Moderator & Geeks Gaming Huvudadmin