Har rätt dålig koll på HPC-marknaden, med det lilla jag känner till om den säger faktiskt att Nvidias fördel är klart mindre där jämfört med övriga marknader.

Orsak? HPC-marknaden är speciell i det att både HW men även programvara är betydligt mer specialdesignad för en specifik uppgift och specifik HW vilket gör Nvidias överlägset viktigaste fördel, långt bättre och mer mogen programvara för GPGPU, mindre viktigt.

Så fort man lämnar HPC är det just AMDs programvara som fallerar, de är inte inte ens tvåa efter Nvidia. Realistiskt är AMD på fjärde plats efter Apple och Intel.

Apple är en bra bit efter Nvidia när det kommer till stöd, men de har idag en klar andraplats i hur mycket som stöds "out-of-the-box". Intel har nått hit mycket p.g.a. att de dels började satsa på OneAPI långt innan deras GPUer kom ut på marknaden + deras MKL användes redan tidigare i många program på CPU och med OneAPI får MKL även GPGPU stöd.

AMD pushar ROCm 6.x för MI300, de säger bl.a. detta

"Important: The next major ROCm release (ROCm 6.0) will not be backward compatible with the ROCm 5 series"

Det är inte ett tecken på mogen programvara. En programvara som i praktiken är en shamless rip-off på Nvidias CUDA. D.v.s. man säger redan från start: vi är den billiga kopian som alltid kommer ligga en eller ett par generationer efter originalet (namngivningen är en rak översätt från Nvidias cuXyz till hipXyz).

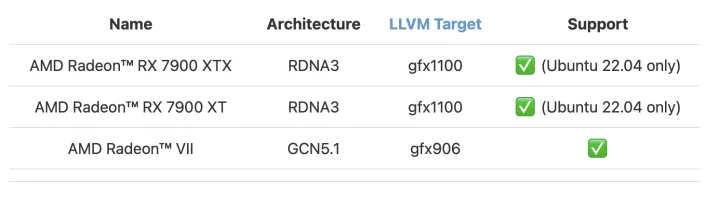

Vidare, detta är officiella stödet man ger för ROCm på konsument GPUer

<Uppladdad bildlänk>

Jämför det med Nvidia, CUDA fungerar på alla deras GPUer (från modeller som 1030 till datacenter). Mängde applikationer som har stöd för CUDA är långt före alla andra.

Intel och Apple har inte lika bra stöd, likt Nvidia har de stöd för alla aktuella GPUer men de har inte alls stöd lika långt bak. Apple har redan delvis börjat droppas stödet för Radeon, även om det mesta fortfarande fungerar. Intel stödjer delvis GPUer från Broadwell, men mer avancerade saker fungerar i praktiken bara med Arc (t.ex. Blender, GPGPU-acceleration av AI, m.m.). Men man stödjer alla Arc, inklusive kommande iGPUer i Meteor Lake (fast gissar att de likt AMDs iGPUer som bästa drar jämt med Apple instegsmodeller och är helt chanslösa med Pro/Max modellerna).

Specifikt för GPGPU är frågan varför någon tycker ROCm är en bra idé. Ingen annan än AMD använder det, samtidigt finns en vettig standard ("open-source" är inte samma sak som "standard") i form av Khronos SyCL. Visst gäller det första även för CUDA, men nu råkar Nvidia fått det till branschstandard p.g.a. att tekniskt överlägsenhet under många många år...

SyCL är skillnad från OpenCL faktiskt är bra! För de som inte gillar Apple: OpenCL designades av Apple så skyll på dem för att i praktiken ge GPGPU-marknden till Nvidias CUDA under många år (det var uppenbart för "alla" hur brutalt mycket bättre CUDA alltid varit jämfört med OpenCL)...

Intel må ha en del egen APIer i OneAPI, men OneAPIs GPGPU-del bygger ändå helt SyCL. ARM-lägret (minus Apple som kör Metal Compute) kör också på SyCL. Intel har också lagt in SyCL stöd för Nvidias GPUer i OneAPI, inte för att de vill utan för att de fattar att de måste givet Nvidias dominas.

Kul att du också upptäckt fördelarna med Apples produkter! Men du vet då också att denna produkt riktar sig mot HPC-marknaden samt datacenter, Apple har egentliga inga produkter riktade mot den marknaden.

Men som du som Apple-fan vet, men kanske inte är lika självklart för de flesta på SweC, är att det speciella med Apple Silicon är att det i praktiken är de enda konsumentprodukterna som realistiskt kan användas för att utveckla och testa de dataset som Hopper och MI300 riktar sig mot.

Orsaken är att t.ex. de mer avancerade LLMs (Large Language Models) som finns får inte alls plats i de 24 GB RAM som AMD/Nvidias toppmodeller på konsumentsidan har. Finns inte tillräckligt med VRAM går det i praktiken inte att köra dessa laster på ett vettigt sätt.

Apple M3 Max har inte samma prestanda som MI300 och H100, men det går att utrusta Apples system med liknande mängd VRAM. Apples fördel är, kanske lite oväntat, ett långt längre pris för att kunna köra den här typen av laster.

En M3 Max med 128 GB RAM är 5-7 gånger billigare jämfört med H100, MI300 priset är vad jag vet inte satt än, men det lär hamna i samma nivå som H100 (så någonstans runt 250k-500k SEK per kort).

Du får fortsätta posta här så kanske fler fattar de tekniska fördelarna med