Nu har jag fått använt min skärm tillräckligt mycket för att kunna ge mitt första intryck av den.

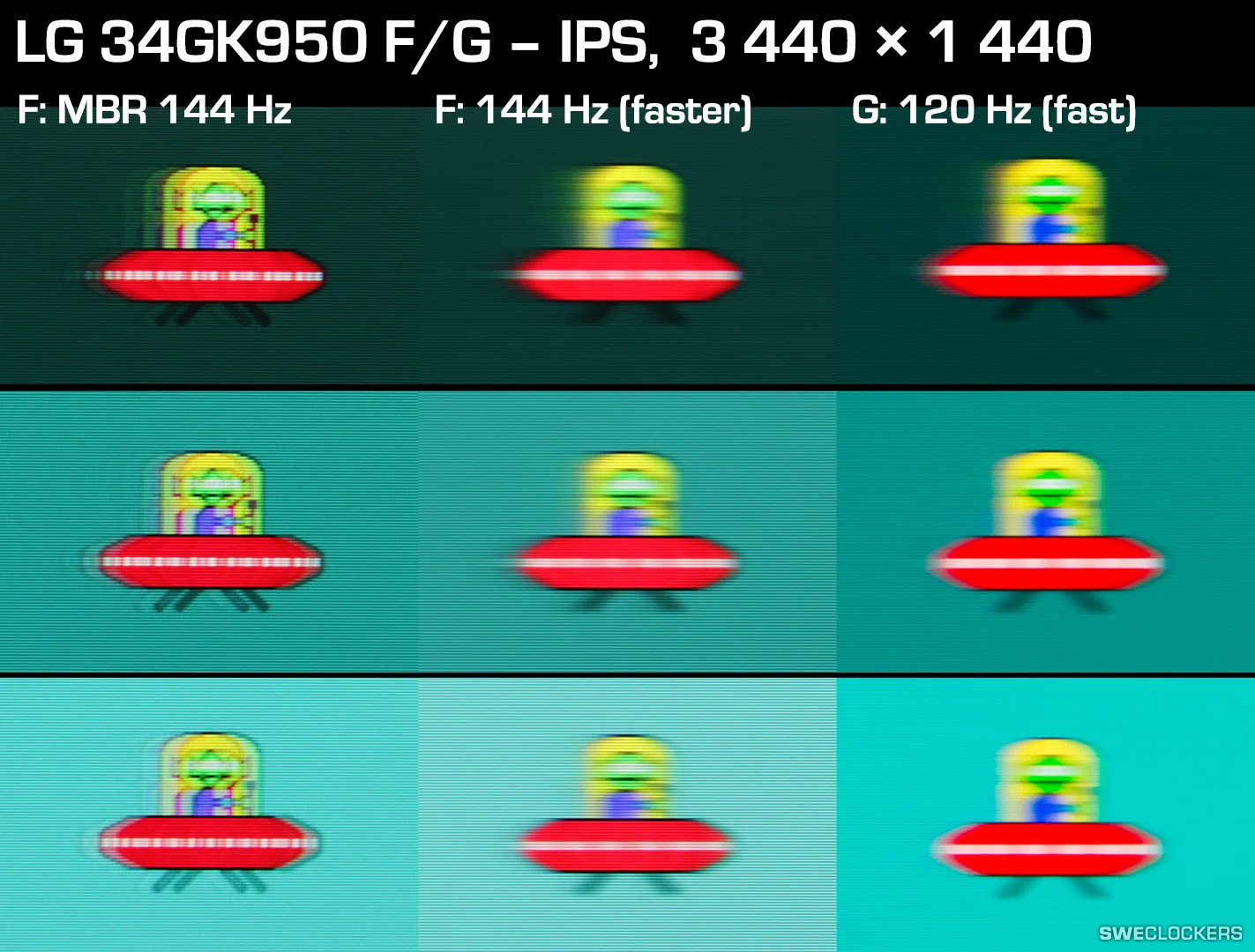

Jag har en LG34GK950G.

Först av allt så är jag grymt nöjd med storleken, känns riktigt nice vid spel o redigering av film.

(lite ovant med så stor panel sedan jag gick från en ASUS 24" VG248QE 144Hz").

När det kommer till spelandet/färgåtergivning/uppdateringsfrekvens/eftersläpningar etc etc..

Med handen på hjärtat kan jag ej se något negativt överhuvutaget med min skärm.

Vid spelande i BF5(enda spelet jag lirar)med 120mhz, ULTRA 3440x1440 med DX12 så har jag en riktigt flytande bra/skarp upplevelse av vad jag ser framför mig, upplever Inga eftersläpningar.

Vid videoredigering/bild hantering så finns det inte heller här något negativt att säga enligt mig,

i jämnförelse med min föregående skärm så är detta ett J-VLA lyft för min del.

Färgåtergivning känns mycket bättre i alla anseenden.

För att inte prata om storleken som gör allt mycket lättare för ändamålet.

Skärmens meny är väldigt enkel att använda och man kan spara 2st olika profiler om så vill.

Det finns några förvalda profiler att välja på som snabbt ger en bekvämare slösurf/läsnings upplevelse så man slipper anstränga ögonen så mycket som i "Gaming profilerna med högre contrast"

Skärmen har en riktigt snygg RGB belysning på baksidan där man kan välja bland flertalet färger och rörelse mönster, det går att justera ljusstyrka och det går även att stänga av den helt om så önskas.

Det enda "negativa" som jag kan tänka mig att andra kan klaga på är det så kallade "ips glow".

Har denna IPS GLOW? Svar ja, jag har det mästadels i hörnena på vänster sida.

Detta är dock inget jag ser överhuvudtaget vid min typ av användning så jag har aldrig riktigt

förstått problematiken eller vad det är som stör vid användning/endamålet av skärmen?

Hur som, smaken är som baken, delad.

Skärmen står även riktigt stabilt på sin deskreta spagat liknande V-fot.

Själva infästningen från foten/juster halsen som fästs i skärmen känns dock si sådär kvalitetsmässigt måste jag medge, var riktigt nojig att den skulle lossna i början men har insett att detta inte är någonting att ora sig för men hade uppskattat om det faktiskt fanns skruvhål som var avsett för just detta, att fästa fast skärmen i foten, nu är det något glappigt "klick-in-system".

Vad mer kan det finnas att säga om skärmen...

Förutom att jag är riktigt jävla apnöjd med inköpet av just denna skärm så tycker väl jag att prislappen är lite väl saftig, tycker dock det är värt det om man råkar ha råd just den månaden.

Denna skärmen mötte iallafall alla mina förväntningar och mycket mer där till.

Aloha!