CPU: 5900x. Mem:64GB@3200 16-17-17-34-1T. (ImDIsk)

GPU: 1080 Ti@ca 6-7%OC. Sound: SB-Z -> toslink (DTS)-> old JVC. MB Realtek to Z-2300 for VOIP.

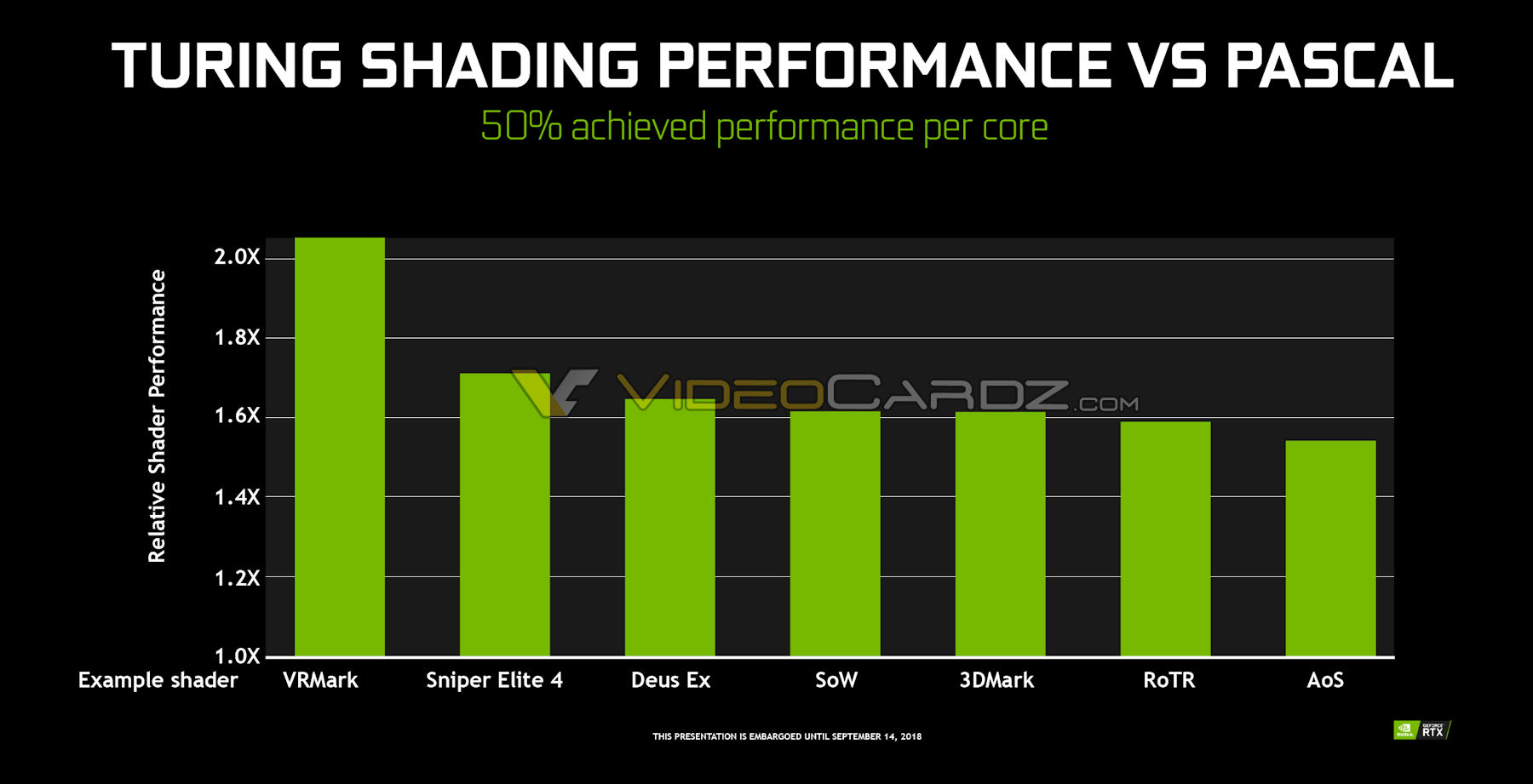

Nvidia "Turing" Geforce RTX 2080 presterar 50 procent bättre än GTX 1080

Fractal Design Meshify 2 Compact w/ Dark Tint | Intel i5 12600K | Asus ROG Strix B660-F | 32 GB Corsair DDR5 5600 MHz CL36 | MSI Geforce RTX 3060 TI Ventus 2X OCV1 | 512 GB Samsung Pro 850 SSD + 2TB WD Black SN850 NVME PCI-E 4.0 | Corsair RM750X |

CPU: 5900x. Mem:64GB@3200 16-17-17-34-1T. (ImDIsk)

GPU: 1080 Ti@ca 6-7%OC. Sound: SB-Z -> toslink (DTS)-> old JVC. MB Realtek to Z-2300 for VOIP.

14900KF--Apex Encore--RTX 4090--G.Skill 2x24GB DDR5-8000--Dynamic Evo XL

12900K--RTX 2080Ti--Gigabyte Z690 Aorus Master--4X16GB DDR5 6000

Ljud: Lewitt Connect 6--Shure SM7B

Skärmar: Neo G8 4K 240hz--Huawei 3440x1440 165hz

Coca Cola missbrukare Förbjuden dryck för mig pga diabetes

AMD älskare

Katt älskare

ASUS Prime B350 Plus, AMD Ryzen 5 1600X, Sapphire R9 390 8GB, 16GB Gskill Flare X 3200

Används för korsord online, och harpan.

Moderkort: ASUS Crosshair VIII Dark Hero, CPU: R9 5900X @4,4GHz, RAM: Corsair Vengence DDR4 32Gb @3600MHz, GPU: RX7900XT Red Devil, Förvaring: Kingston KC3000 512Gb, WD Black SN750 2TB, Samsung 750 500Gb SSD och 2x Seagate Barracuda 4Tb i raid 1, Ljudkort: Creative Sound Blaster ZxR

7800X3D | 7900XTX Merc 310 Alphacool | ASUS B650E-F | G.Skill 6000Mhz 32GB CL30 | SN850X | EK Quantum custom loop | Be Quiet 900 Dremel Edition | ASUS Xonar STX + Sennheiser HD650 | Corsair RM1000x | Monitor: LG C2 42 | Nintendo Switch | TV: LG C1 65

www.obscured.se mrtg.obscured.se - erik.hennerfors@obscured.se - See ya in cyberspace

ozzed.net Min egenkomponerade 8-bit musik. Gillar du musiken från gamla klassiska NES eller Gameboy och liknande är det värt ett besök. :) Jag finns också på Spotify, Bandcamp, Jamendo, Youtube, och du kan även följa mig på Twitter och Facebook.

Vet du att du har fel? Signalera detta tydligt med Argumentationsfel och gärna Whataboutism.

🎮 → Node 304 • Ryzen 5 2600 + Nh-D14 • Gainward RTX 2070 • 32GB DDR4 • MSI B450I Gaming Plus AC

🖥️ → Acer Nitro XV273K Pbmiipphzx • 🥽 → VR: Samsung HMD Odyssey+

🎧 → Steelseries arctic 7 2019

🖱️ → Logitech g603 | ⌨️ → Logitech MX Keys

💻 → Lenovo Yoga slim 7 pro 14" Oled

En ny signatur

Playstation 4 + Nintendo Switch

R7 5800x3d - MSI B450 - RTX 3080 TUF - EVGA 650w G3 - ASUS PG279Q

AP201 | B650M | 7800X3D | 32GB | RTX 3090

G613 | G502 X | PRO X | G3223Q | PG279Q

OLED55C9 | PS5 | Switch

..:: trickeh2k ::..

Windows 11 Pro - Ryzen 7 7800X3D - ASUS TUF B650-PLUS - Kingston FURY Beast DDR5 64GB CL36 - MSI MAG A850GL - MSI RTX 4080 VENTUS 3X OC - Acer Predator XB271HU - ASUS VG248QE - QPAD MK-85 (MX-Brown)/Logitech G PRO Wireless - Samsung 960 EVO 250GB, Samsung EVO 860 500GB, SanDisk Ultra II 480GB, Crucial MX500 1TB, Kingston KC3000 2TB - Steelseries Arctic 5 - Cooler Master Masterbox TD500 Mesh V2

Min spel rigg:FD Define R4|VX 550W|i5 2500K|Corsair LP 4GBX2|Mammabräda P67 Extreme4|GTX 670 windforce|23tum u2312hm

Min gamla/HTPC:AMD 6000+|Ram 2GbX2|Radeon HD5770| XFX 450/nu XFX 550

Mitt bygge: ByggloggFri frakt INET:Fraktfritt sweclockers vid köp över 500kr

#Gilla inlägg som är bra & Använd citera/@"namn" vid snabbt svar