Observera att samma trivselregler gäller i kommentarstrådarna som i övriga forumet och att brott mot dessa kan leda till avstängning. Kontakta redaktionen om du vill uppmärksamma fel i artikeln eller framföra andra synpunkter.

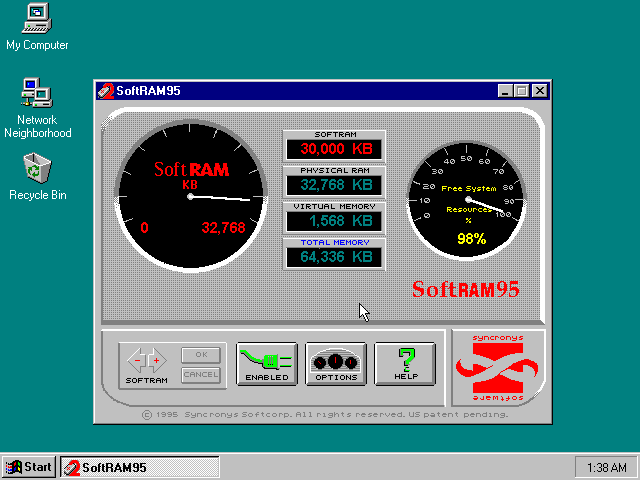

Svensk komprimeringsteknik dubblar primärminnens kapacitet och bandbredd

Visa signatur

Visa signatur

| PM:a Moderatorerna | Kontaktformuläret | Geeks Discord |

Testpilot, Skribent, Moderator & Geeks Gaming Huvudadmin

Visa signatur

5900X | 6700XT

Senast redigerat

Visa signatur

Ryzen 3900X || ASUS ROG Strix X570-E Gaming || ASUS GeForce RTX 2080 8GB DUAL EVO || Corsair Vengeance RGB PRO DDR4-3200 || ACER - XB280HK 28

Visa signatur

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Visa signatur

| EVGA Z170 FTW | i7 6700k | ASUS RTX 3070 | 16GB DDR4 3200MHz | Cooler Master V850 | Samsung 840 Evo 250GB + 2x WD Black 500GB + Seagate 2TB SSHD + Samsung 970 Evo M.2 1TB|

Visa signatur

| EVGA Z170 FTW | i7 6700k | ASUS RTX 3070 | 16GB DDR4 3200MHz | Cooler Master V850 | Samsung 840 Evo 250GB + 2x WD Black 500GB + Seagate 2TB SSHD + Samsung 970 Evo M.2 1TB|

Visa signatur

kill -s SIGCHLD `pidof Kenny`

bash: Oh my god, they killed Kenny

init: You Bastards

Senast redigerat

Visa signatur

kill -s SIGCHLD `pidof Kenny`

bash: Oh my god, they killed Kenny

init: You Bastards

Visa signatur

5900X | 6700XT

Visa signatur

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Visa signatur

kill -s SIGCHLD `pidof Kenny`

bash: Oh my god, they killed Kenny

init: You Bastards