Skrivet av Dinkefing:

Tror det är ett betydligt utgångsläge än 2012 för Windows RT och 2017 när Windows 10 lanserades med ARM-stöd men det kommer gå segt väldigt segt. De flesta stannar nog kvar på x86 för bakåtkompatibliteten och att de flesta program redan finns till x86. Nu tror jag Yoshman kommer hoppa in och förklara att så inte är fallet men jag tror jag har rätt.

Det är nog inte många utvecklare som orkar gå in och koda nya versioner bara för att Qualcomm släpper begränsade bärbara med deras egna chip.

Hej, eftersom du tydligen så gärna vill ha min åsikt här

Objektivt sett finns inte de flesta program till x86. Det har under många år sålts ungefär 100 Arm CPUer per x86 CPU, de flesta program finns på andra plattformar än Windows. Ca 300 miljoner x86 CPUer per år, strax under 30 miljarder Arm CPUer per år.

Däremot körs absolut de flesta Windows-program på x86, och det kommer troligen att fortsätta vara så under lång tid.

Det är inte alls säkert att ARM64 kommer att bli en succé på Windows, både Qualcomm kan förstöra det (genom för höga priser, dåliga drivrutiner, inte tillräckligt bra roadmap framåt, etc) och Microsoft (“marknaden” måste verkligen känna att Microsoft går all-in).

Det som talar för att i alla fall Microsoft kommer att göra sin del är att de själva satsar hårt på ARM64, de har flera egna server-designer som är ARM64-baserade. Efter mer snack än verkstad har de nu också fixat riktigt bra ARM64-stöd i .NET, Visual Studio, MS Office etc.

Många på SweC använder sin dator primärt för spel. Snapdragon X Elite verkar vara marginellt bättre än Intels/AMDs iGPUer för detta, d.v.s. knappast någon spelplattform. Vi får se om det finns någon sanning bakom att Nvidia ska släppa sin egen ARM64 CPU 2025, men de ska ju också ge sig på desktop (deras nuvarande ARM64-plattformar är ju bara för server, Grace, och inbyggda system, Tegra och använder Arms CPU med Nvidias GPU).

För 20 år sedan var det betydligt svårare att flytta program mellan CPU-arkitekturer, av en rad olika tekniska orsaker. Nästan ingen av dessa tekniska orsaker finns längre kvar idag, det är helt trivialt att stödja flera CPU-arkitekturer med allt som är skrivet i “moderna” språk/ramverk. Spelmotorer som UE5/Unity stödjer redan ARM64, så inget problem där heller.

Skrivet av Det Otroliga Åbäket:

Kan de landa på ett pris under Air också, utan för stora kompromisser - och om man kan köra annat än Windows på dem- så kommer jag definitivt vara intresserad av att komplettera med en sådan.

Jag håller med. Är inte primärt en MacOS-användare, har totalt sett använt Linux på skrivbordet betydligt längre än MacOS. Jag vill bara ha ett bra *NIX-system.

Qualcomm har inte sagt mycket om Linux, men de har nämnt att det ska finnas bra stöd för Snapdragon X Elite på Linux. Min gissning är att det, åtminstone initialt, i praktiken kommer att handla om bra stöd för WSL2 i Windows. Om Apple går helt crazy på något sätt med MacOS/M-serien, är WSL2 OK för mig, så jag kan absolut tänka mig en Windows-laptop framöver.

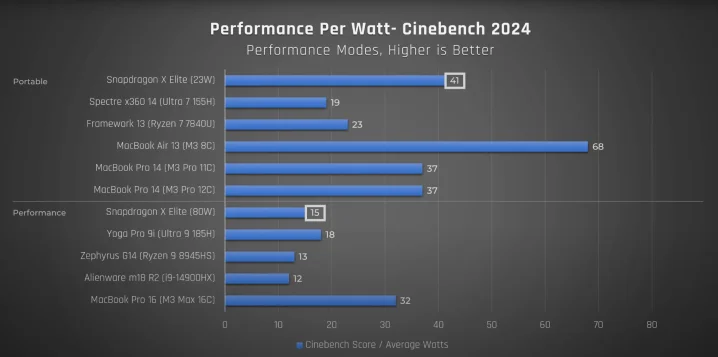

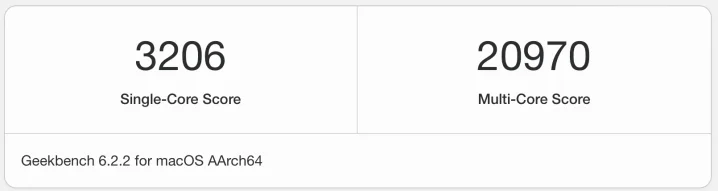

Att något annat än MacOS har känts otänkbart sedan hösten 2020 beror specifikt på att Apples M-serie är så löjligt mycket bättre än vad Intel/AMD har att erbjuda. Så just nu skulle jag i praktiken vilja få betalt för att använda en x86-baserad laptop…

Därför är jag väldigt entusiastisk över Snapdragon X Elite, detta trots att Qualcomm flera gånger har visat att de inte är det enklaste företaget att ha att göra med. Men om denna lansering går bra kommer det inom ett par år att finnas ett gäng ARM64 CPU-tillverkare att välja mellan. Ryktet säger att ARM Cortex X5 också ska prestera som high-end på skrivbordet (den bör lanseras i april/maj, vilket är när Arm brukar ha sin årliga uppdatering). Redan Cortex X4 har bättre ISO-frekvensprestanda än något från Intel/AMD, men den kan inte klockas högre än 3,2-3,3 GHz någonstans.