Vad Intel föreslår här har faktiskt aldrig gjorts innan. Det betyder inte att det kommer vara en succé, det betyder bara att det inte testas tidigare och konstateras vara en dålig idé.

Det Lucidlogix Virtu verkar handlat om är inte ens i närheten av vad som föreslås här. Däremot har den idén visat sig inte vara helt galen, men den implementation som Lucidlogix gjorde hade en rad tillkortakommanden som man senare löst med extra HW. De siktade delvis på vad Nvidia idag kan erbjuda med adaptive v-sync. Om man kisar lite kan man också hävda att de försökte göra det G-sync och Freesync idag erbjuder. Idag fungerar teknikerna, så idén var inte fel. Men vi vet idag att det krävdes extra HW-stöd.

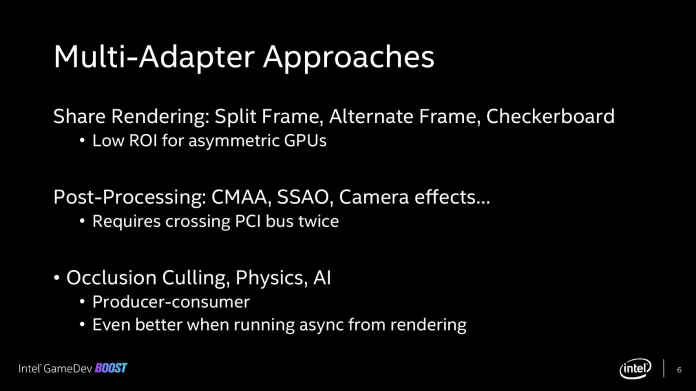

Kikar man på denna bild

så kan man se att både AMD och Nvidia haft stöd för första punkten, det fungerade ett tag förutsatt att man hade två identiska GPUer. AMD försökte även köra den första med iGPU+dGPU, det var dömt att misslyckas då en asymmetrisk konfiguration alltid kommer leda till microstutter.

AFR-tekniken (vilket var den SLI/Crossfire i praktiken alltid utnyttjade) dog p.g.a. att allt fler renderingstekniker använder föregående scen(er) som indata till aktuell scen. Detta gjorde metoden allt mindre effekt, vinsten blev till slut inte på något sätt värt arbetsinsatsen.

Punkt två har Intel gjort ett försök på. Det gav i vissa lägen en vinst, men den var för liten för att vara värd extraarbetet just p.g.a. det som listas. Att dåvarande Intel GPU var allt annat än kraftig gjorde ju inte saken bättre.

Punkt tre har så här långt aldrig testas och innan DX12/Vulkan var det inte ens tekniskt möjligt. Är fortfarande så att det är tveksamt om kraften i Skylakes iGPU är tillräckligt hög för att vara värt besväret, men gissar att målet är att använda detta för kommande Xe. För saker som partikeleffekter, AI (neuronnätverk) och liknande har ändå redan Skylakes iGPU samma kapacitet som lite mer än 3 st Skylake/Zen2 kärnor som jobbar med AVX.

Spel använder sällan AVX då det sänker frekvensen och CPU-delen jobbar primärt med heltal, när CPUn jobbar med SSE motsvara dagens standard iGPU i Skylake lite mer än 6 Skylake/Zen2 kärnor och Ice Lake motsvarar mer än 16 Skylake/Zen2 kärnor för just de här uppgifterna.

I det korta perspektivet lär detta knappast användas speciellt mycket. Vi har ju sett hur extremt sakta spel ökar skalning med CPU-kärnor. Men på 5-10 års sikt kan det bli en väldigt intressant teknik. Det kan också stöta på patrull och likt de två första bli ännu en i raden av misslyckade tekniker.

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer