Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

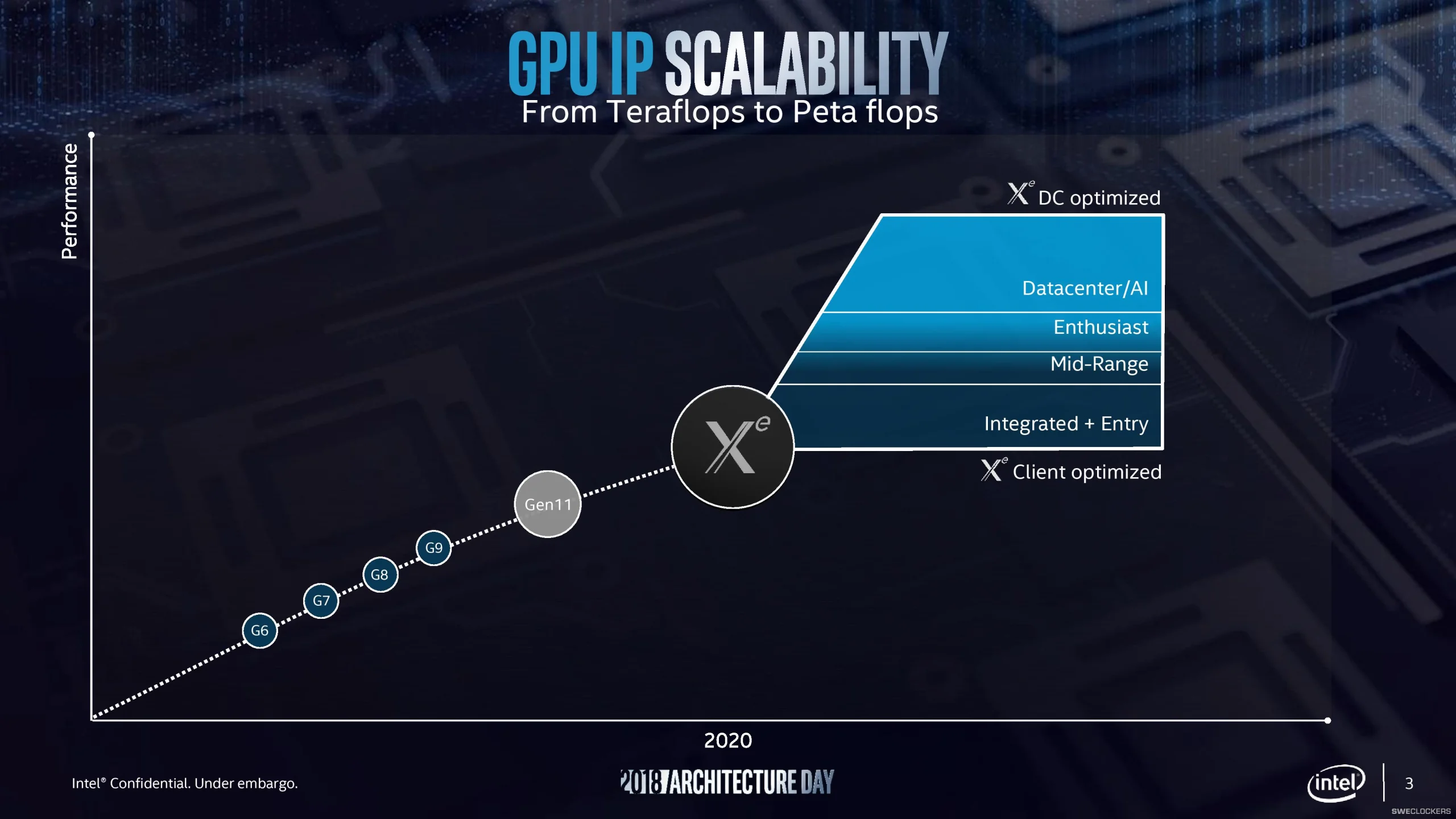

Intel visar konceptbilder på Xe-grafikkort

Visa signatur

Visa signatur

ASUS ROG Crosshair X670E Gene| AMD Ryzen 9 7800X3D Delidded | Custom EK Watercooling| WD Black SN850X 1TB + WD Black SN850X 2TB| Corsair Vengeance, DDR5-6600 64GB (2 x 32GB) @6400MHz CL 30-38-38-76| AMD Radeon RX 7900 XTX| LG UltraGear 45GR95QE OLED| MSI MPG A1000G PCIE5 1000W| Lian Li O-11 EVO|

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Senast redigerat

Senast redigerat

Visa signatur

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Senast redigerat

Visa signatur

Senast redigerat

Visa signatur

MSI GT73VR Titan

Visa signatur

Star Citizen ❤

Visa signatur

---CPU---Intel Core 2 QUAD Q9550 2.83GHz 12MB FSB1333

---RAM---DDR2 PC2-8500 1066MHz CL5-5-5-15

---MOBO---Maximus II GENE ( P45/ICH10R , Dual-channel, DDR2 1300)

---PSU----Corsair HX520W ---GPU--- Radeon HD6850

Visa signatur